Señal de audio

[gL.edu] Este artículo recoge contribuciones de José María Díaz Nafría [JDíaz], Juan Muñoz Roche, elaboradas en el contexto de la Clarificación conceptual en torno a los Sistemas de transmisión, bajo la supervisión de J.M. Díaz Nafría.

Definiciones

La señal de audio o señal sonora se refiere a la señal empleada para establecer un canal de comunicación en el que -utilizando la nomenclatura del modelo de comunicación de Shannon- los fenómenos físicos presentes en la fuente y el destino de la información consisten en sonido. Como se ha discutido en el artículo sonido, lo que principalmente va a permitirnos hablar de señal sonora es la capacidad de que en el destino se genere una onda mecánica susceptible de crear una sensación sonora en el sujeto -receptor último de la comunicación-. Sin embargo, dependiendo de la naturaleza de los procesos involucrados en la generación de la señal y la ulterior conversión a fenómeno acústico, las características de la señal pueden ser muy diferentes. No obstante, a tenor de la sensibilidad del oído sí podemos hacer una descripción de qué características puede llegar a tener la señal sonora.

Señal sonora analógica

El caso más sencillo es el de la señal analógica, especialmente antes de que esté involucrada en procesos de modulación, ya que si el proceso de transducción de la onda de presión acústica en señal eléctrica fuera simplemente lineal, ésta no sería más que una réplica exacta de la onda de presión acústica. Es decir, donde representa la onda de presión acústica, la señal eléctrica y el factor de proporcionalidad que dependerá fundamentalmente de la sensibilidad del dispositivo transductor, es decir, del micrófono.

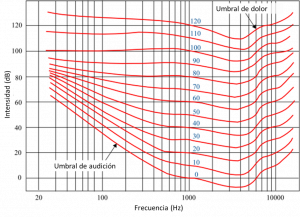

Bajo estas simples consideraciones, lo que esencialmente caracteriza la señal sonora es la sensibilidad del oído en cuanto al rango de frecuencias e intensidades audibles por los seres humanos. El rango de frecuencias audibles se encuentra aproximadamente entre los 20 y los 20.000 Hz, mientras que el margen dinámico de la señal entre el umbral de audición y el de dolor depende de la frecuencia (ver nivel de intensidad sonora). Como puede verse en la figura 1 de curvas isofónicas (cada una de las cuales supone una misma sensación de intensidad sonora), la sensibilidad varía fuertemente con la frecuencia, siendo máxima en torno a los 3000 Hz y presentando el margen dinámico -entre los extremos antes mencionados- una amplitud máxima de unos 120 dB entre los 1000 y los 5000 Hz.

Estas características suponen en cierto modo los límites de audición en condiciones óptimas para un oído estándar que no haya experimentado pérdida de capacidades auditivas. Sin embargo, como en circunstancias ordinarias no es posible lograr esas calidades, ni tan siquiera sería saludable exponer a los sujetos a niveles que pudieran ser perjudiciales, el máximo margen dinámico que se considera de interés práctico es el de 100 dB (similar al preservado en grabaciones digitales de alta fidelidad), aunque en la mayor parte de las aplicaciones analógicas éste es significativamente menor (70-80 dB).

Debido a que las fuentes de la señal de sonido pueden ser de lo más variado (incluyendo la música, el habla, el canto de los pájaros, el sonido del oleaje, el chasquido de una nuez al partirla, o lo que en general llamamos ruido en el sentido de sonido no articulado) carece de sentido hablar de una caracterización estocástica del sonido en general que a su vez nos permita hablar de su distribución espectral de potencia. Sin embargo, sí podría tener sentido hacerlo, y a menudo se hace, de algunas fuentes específicas de la señal de sonido, como el canto de un ruiseñor, las sinfonías de Beethoven, etc. En cualquier caso, si se considera el conjunto de señales sonoras utilizadas comunmente, podemos hacer una mínima descripción de sus caracteríticas espectrales indicando que su valor máximo se situa típicamente entre los 200 Hz y los 600 Hz. Pero además podemos hacer una caracterización más específica de una fuente de sonido en términos de tres parámetros fundamentales de las señales típicas generadas por dicha fuente:

- Intensidad, correspondiente a la intensidad sonora del sonido generado tras la transducción de la señal eléctrica a onda de presión acústica, y que puede vincularse directamente a la potencia de la señal eléctrica e indirectamente a la sonoridad. Para una fuente sonora real esta intensidad es normalmente fluctuante, de modo que si hablamos de la potencia instantanea o la potencia media en intervalos de tiempo breves podemos observar que, en general las señales de audio tienen un margen dinámico que, si conocemos la cadena completa de transducción, podemos vincularlo a la sensación de intensidad sonora que causa en un oyente estádar;

- Tono o altura (pitch en inglés) que corresponde a la frecuencia fundamental del sonido, es decir, si la fuente fuera sinusiodal pura se trataría de la frecuencia de dicha sinusoide, de lo contrario, la frecuencia en la que se concentra la mayor parte de la energía.

- Timbre, que permite distinguir entre varios sonidos del mismo tono e intensidad producidos por fuentes distintas, dependiendo de las amplitudes relativas de los distintos armónicos que componen el sonido. En el caso de fuentes cuyo tono no está muy definida, es el timbre el que principalmente permite distinguirlos.

A menudo estos parámetros se completan con consideraciones acerca de la temporalidad, como, por ejemplo, la duración en la que la señal tiene una determinada intensidad.

Por otra parte, la señal de audio en el destino del sistema de comunicación, como resultado de todos los procesos acaecidos entre ambos extremos, no solamente responde a la señal que antes hemos idealizado como proporcional a la onda de presión acústica de la fuente sonora, sino que vendrá acompañada de perturbaciones que podemos modelizar en términos de una señal de ruido, . Según ese modelo, podemos decir que la señal sonora recibida, , está contaminada por una señal de ruido: y para su caracterización relativa solemos recurrir a la relación señal a ruido.

Efectos biaurales (sonido estéreo y envolvente)

Otra caracterítica fundamental de nuestra audición es nuestra capacidad de discernir la procedencia de la fuente en virtud de la diferencia entre la onda de presión acústica que alcanza a cada oído y la directividad de nuestros pabellones auditivos, lo cual ofrece al oyente una cierta capacidad de discernir las fuentes de sonido en sentido principalmente horizontal; percepción que se basa en la diferencia en la intensidad (más burda) y la diferencia temporal entre ambas de ondas (más fina).

Teniendo en cuenta que la percepción espacial depende en última instancia de la diferencia entre la onda de presión que alcanza cada uno de los tímpanos, una señal que reproduzca plenamente los efectos biaurales sobre un oyente, como por ejemplo, una persona que escucha música con unos auriculares, debería ser capaz de reproducir una onda acústica diferente en cada uno de los oídos. Para ello basta disponer de una señal para cada oído, derecha e izquierda, o cualquier combinación equivalente, siendo lo más normal la combinación de suma de las señales derechar e izquierda, que es compatible con la señal monoarural, y su diferencia cuyo margen dinámico es inferior. En estos casos hablamos de señal de audio estereofónica o de sonido estéreo.

Sin embargo, para algunas aplicaciones no solo se desea reproducir el sonido que va destinado a un oyente individual, con independencia del entorno que lo rodee, sino que se desea reproducir el sonido en relación con dicho entorno, de modo que pueda percibirse la procedencia de la fuente en una relación derecha/izquierda, adelante/atrás y arriba/abajo. Obsérvese que dicha distinción presupone una relación entre el sujeto y un entorno de audición, en el que se situan múltiples altavoces, ubicados en posiciones diferentes, siendo cada uno de estos destinatario de un canal diferente). Para la generación de este sonido, conocido como sonido envolvente, se requieren entre dos y nueve canales. Dos para el sonido estereofónico normal, cuatro para el cuadrofónico y nueve cuando uno de los canales va destinado al techo.

Señal sonora digital

La caracterización anterior puede resultar suficiente para hablar de la señal de audio analógica, ya que el procesado analógico suele restringirse al filtrado en frecuencia y la limitación de amplitud. Sin embargo, en la medida que el procesado de la señal digital ofrece muchas más posibilidades, resulta conveniente explorar con más profundidad las caracteristicas de las señales de audio, que en última instancia dependen de nuestra capacidad de percepción auditiva (objeto de la psicoacústica), lo que as su vez nos permitirá entender mejor las técnicas de codificación digital de la señal de audio.

En efecto, debido a la no linealidad de nuestro sistema auditivo (manifestado entre otras cosas en el hecho de existir los umbrales de audición a los que nos referíamos más arriba) se producen varios efectos de gran relevancia:

- El enmascaramiento de una parte de la señal por otra cuya intensidad y frecuencia puede ser diferente, correspondiente a que la respuesta neuronal de ésta última (señal enmascaradora) inhibe a la que se generaría por parte de la señal enmascarada en caso de que la otra no estuviera presente, diferenciándose entre:

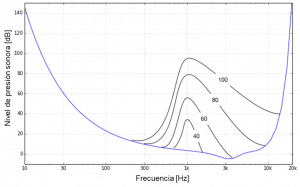

- Enmascaramiento en frecuencia consistente en la elevación del umbral de audibilidad en función de la frecuencia debido a la presencia de un determinado tono de una frecuencia e intensidad dada, como se ilustra en la figura 2 para el caso de un tono de 1 kHz y diferente intensidad. Dicho enmascaramiento, que cambia significativamente con la frecuencia y la intensidad, supone que los tonos cuya intensidad y frecuencia se encuentre por debajo de dicho umbral de enmasccaramiento no darán lugar a sensación auditiva.[1] De esta forma, los patrones de enmascaramiento constituyen un aliado fundamental para la codificación eficiente de la señal de audio.

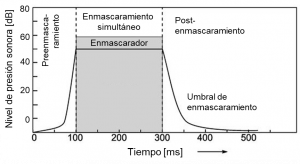

- Enmascaramiento en el tiempo consistente en que un pulso enmascarador, evita que se perciban partes de la señal que se encuentren por debajo del umbral de enmascaramiento que distingue un preenmascaramiento un enmascaramiento simultáneo y un postenmascaramiento, como el representado en la figura 3, lo cual se debe no solo a la alinealidad del sistema auditivo, sino también a su respuesta limitada en banda. De nuevo, este enmascaramiento hace posible el prescindir de partes de la señal que al no crear sensación sonora carecen de información para la comunicación sonora.

- La generación de tonos subjetivos inexistentes en la señal de audio debido a la no-linealidad del sistema auditivo, que da lugar a armónicos y productos de intermodulación (donde los de mayor importancia son los cúbicos debido a que su frecuencia queda en el entorno de los tonos involucrados, por ejemplo, , y los cuadráticos, que aunque queden más separados de los tonos involucrados, por ejemplo su intensidad es normalmente mayor). Además de la percepción de los tonos subjetivos, este fenómeno puede dar lugar al enmascaramiento de otras frecuencias en el entorno de los productos de intermoduación.

Como se verá más abajo al referirnos a algunos formatos estandarizados de la señal digital, la utilización de técnicas de codificación de fuente que permiten sacar partido a estos fenómenos de enmascaramiento hacen posible lograr una alta eficiencia en la codificación de la señal digital. Aún así lograr una eficiencia espectral similar a la de la comunicación de audio analógica solo se logra a expensas de un alto coste computacional.

Calidades y formatos de la señal sonora

Las características que referimos más arriba acerca de la señal de audio analógica -en cuanto al ancho de banda y margen dinámico al que es sensible nuestro sistema auditivo- establece la calidad óptima que permitiría una reproducción absolutamente fiel al sonido original -asumiendo la pureza del proceso de transducción al que nos referimos antes, incluidos los filtrados involucrados en acotar la banda de la señal de audio-. El preservar dicha calidad máxima puede ser el objeto de sistemas producción, grabación e intercambio de contenidos de alta fidelidad sonora. Sin embargo, esto no resulta práctico en la mayor parte de los servicios analógicos de telecomunicación sonora, razón por la cual se reducen las exigencias de calidad, que va a venir determinada por dos características fundamentales: (i) la banda de paso de la señal original preservada (con una distorsión máxima que estará acotada), y (ii) la relación señal a ruido, a su vez vinculada a un cierto objetivo de margen dinámico, para lo cual no es suficiente considerar exclusivamente la relación señal-a-ruido -como se desprende de la figura 1-, sino también las distribuciones espectrales de potencia de la señal típica y del ruido esperado, que en general no es constante en toda la banda.

La calidad preservada tiene por objeto lograr eficiencia en la utilización de los recursos para el establecimiento de los servicios en cuestión de modo que estos ofrezcan una calidad aceptable. Ésta se cifra principalmente en términos de la banda de frecuencias, aunque en el diseño de los sistemas se tenga también en cuenta la preservación del márgen dinámico y, en consecuencia, la relación señal a ruido que permite evaluar que, en efecto, se cumplan los objetivos de calidad del servicio en cuestión. Así, es posible hablar de las calidades estandarizadas para la radiodifusión sonora analógica en función de la banda preservada[2]:

- 50 Hz - 5 kHz en radiodifusión de amplitud modulada (AM).

- 100 Hz - 15 kHz para cada uno de los canales (derecha e izquierda) en radiodifusión de frecuencia modulada (FM).

En el artículo sonido nos hemos referido a otras calidades estandarizadas en la transmisión de señales de audio.

Calidad de la señal de audio digital

En el caso de la señal de audio digital la comparación entre unos formatos y otros es más compleja debido a la diversidad de técnicas que podemos poner en escena para filtrar todo aquello que no es propiamente señal de audio, no obstante, existen dos parámteros fundamentales que van a acotar estrictamente la calidad de la señal de audio digital vinculadas al proceso vásico de digitalización, esto es, el muestreo y la cuantificación. En efecto, el primero va a limitar, en virtud del teorema de muestreo, la máxima frecuencia preservada (coincidente con la mitad de la frecuencia de muestreo); mientras que el segundo va a limitar el margen dinámico, como se desprende de lo discturido en el artículo error de cuantificación. A modo de referencia puede considerarse que para calidad telefónica (cuya finalidad es fundamentalmente la comunicación vocal) el muestreo estándar se realiza a 8 kHz, empleando 8 bits por muestra (recurriendo a una cuantificación no uniforme basada en ley A o mu o sus respectivos algoritmos de transcodificación, que supone para las señales telefónicas una relación señal-a-ruido-de-cuantificación de 30 dB y un margen dinámico de 48 dB [3]), mientras que en uno de los formatos de alta calidad musical más difundidos, el de discos compactos (CD), el muestreo se realiza a 44.1 kHz y la cuantificación a 16 bits por cada canal de sonido estéreo (lo que arroja un margen dinámico de ).

En relación a los efectos de enmascaramiento antes referidos, obsérvese que cuando en la codificación (de fuente) de la señal de audio se prescinde de aquellas partes de la señales de acuerdo a tales enmascaramientos, no se está eliminando nada que propiamente pertenezca a la señal de audio, ya que ésta se define como la que da lugar a una sensación auditiva y, por tanto, tales partes de la señal son elementos ajenos. Desde este punto de vista, las técnicas de codificación de fuente empleadas con esta finalidad pueden entenderse como tipos de filtrado, que al igual que el filtrado en frecuencia, purifican la señal de aquellas componentes que no son informacionales para la comunicación sonora. Cuando podemos afirmar que la codificación de fuente actúa de este modo hablamos de una codificación sin pérdidas. En cambio se dice que la codificación es con pérdidas cuando por mor de reducir aún más el régimen binario de la señal codificada se eliminan componentes de la señal original que sí podrían ser perceptibles. En ese caso se procede eliminando aquello cuyo peso en la perceptión es menos notable.

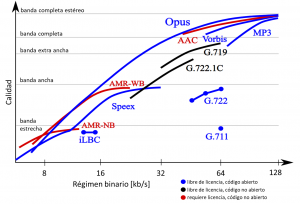

La figura 4 representa una comparativa de algunos estándares populares de codificación de fuente de la señal de audio, representándose en ordenadas una calidad creciente donde la nivel máximo corresponde a la preservación de la calidad completa de la señal y el nivel marcado como banda estrecha correspondería a una calidad similar a la calidad telefónica de banda estrecha, en la cual es perfectamente posible ententer una señal vocal artículada, pero con pérdida de las carácterísticas naturales (de timbre o cromáticas) de la voz en cuestión. En abcisas, se reprenta el régimen binario de la señal codificada, donde podemos ver la convergencia de diversos estándares hacia la calidad completa en torno a los 128 kbps, lo que supone la utilización de un muestreo de unos 44.1 kHz (para evitar distorsión en el filtrado antialiasing, ver aliasing) y algo menos de 1.5 bits por muestra por cada canal estereofónico. De lo que no da cuenta la representación es de la complejidad involucrada, la cual en general es tanto mayor cuanto mayor sea la proximidad a la esquina superior izquierda. Como puede observarse, casi todos los formatos permiten realizar un cierto balance entre la maximización de la calidad ofrecida y la minimización del régimen binario requerido. Para una comparación más exhaustiva de los formatos de codificación normalizados puede consultarse el artículo Comparación de formatos de codificación de audio.

En la tabla siguiente se refieren varias formatos codificados de la señal de audio que dan cuenta de las principales técnicas básicas de codificación de fuente a las que se recurre para lograr adaptar la calidad a los recursos disponibles del canal, que incluyen cuantificación no uniforme, codificación predictiva, codificación diferencial adaptativa y codificación por subbandas. Otras codificaciones normalizadas recurren además a codificación transformacional y codificación estadística.

| Formato de codificación | Calidad | Banda preservada [Hz] | Fm [Hz] | bit/muestra | Rb [kb/s] |

|---|---|---|---|---|---|

| MIC / PCM (UIT-T G.711) Cuantificación no uniforme[4] |

Telefonía banda estrecha | 300 - 3.400 | 8 | 8 | 64 |

| Telefonía banda ancha | 50 - 7.000 | 16 | 8 | 128 | |

| Telefonía banda ancha | 10 - 20.000 | 48 | 2·16 | 2·768 | |

| MICDA / DPCM (UIT-T G.726) Codificación Diferencial Adaptativa[5] |

Equivalente a telefonía banda estrecha de calidad idéntica o ligeramente inferior | 300 - 3.400 | 8 | 5 4 3 2 |

40 32 24 16 |

| Codificación por subbandas (UIT-T G.722) MICDA para cada subbanda[6] |

Equivalente a UIT-T G.711 - banda ancha (128 kb/s) Separación de banda interior y superior El Rb sobrante se emplea como canal de datos |

50 - 7.000 | 16 | 4 + 2 5 + 2 6 + 2 |

48 + 16 56 + 8 64 + 0 |

Código

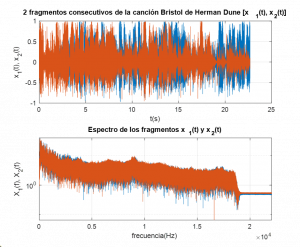

load_Herman.La siguiente función permite cargar el archivo H_D.mp3 (fragmento de la canción Bristol de Herman Dune) y su frecuencia de muestreo (44100 Hz). Se queda con dos fragmentos consecutivos de 1.000.000 muestras (ca. 22.7 s) y devuelve la base de tiempos. Además reproduce el sonido de los dos fragmentos consecutivos en estéreo y representa gráficamente (v. figura 5) los dos fragmentos consecutivos monoaurales como señales temporales simultáneas para facilitar la comparación de sus características en el dominio del tiempo y de la frecuencia.

function [fm,t,x1d,x1i,x2d,x2i] = load_Herman

%% [fm,t,x1d,x1i,x2d,x2i] = load_Herman

% Carga el archivo H_D.mp3 (fragmento de la canción Bristol de Herman Dune)

% y su frecuencia de muestreo (44100 Hz). Se queda con dos fragmentos

% consecutivos de 1.000.000 muestras (ca. 22.7 s) y devuelve la base de tiempos.

%

% Además reproduce el sonido de los dos fragmentos consecutivos en estéreo y

% representa gráficamente los dos fragmentos consecutivos como señales

% temporales simultáneas para facilitar la comparación de sus características

% en el dominio del tiempo y de la frecuencia.

%

% SALIDA

% fm....frecuencia de muestreo de la grabación

% t.....escala de tiempo para las secuencias de 1 Mm (a 44100 Hz)

% x1d...primer fragmento de 1 Mm (canal derecho)

% x1i...primer fragmento de 1 Mm (canal izquierdo)

% x2d...segundo fragmento de 1 Mm (canal derecho)

% x2i...segundo fragmento de 1 Mm (canal izquierdo)

% AUTORES: J.M.Díaz-Nafría

%% MODELO TEMPORAL Y FRECUENCIAL DE LOS DOS FRAGMENTOS BIAURALES

M = 1e6; % Nº de muestras

[x,fm] = audioread("H_D.mp3"); % fm: frecuencia de muestreo

x1d = x(1:M,1)'; % Secuencia canal dch, primeros 22.5 s

x1i = x(1:M,2)'; % Secuencia canal izq, primeros 22.5 s

x2d = x(M+1:2*M,1)'; % Secuencia canal dch, siguientes 22.5 s

x2i = x(M+1:2*M,2)'; % Secuencia canal izq, siguientes 22.5 s

x1 = (x1d+x1i)/2; % Secuencia monoaural (D+I) del fragmento 1º

x2 = (x2d+x2i)/2; % Secuencia monoaural (D+I) del fragmento 2º

X1 = fft(x1); % FFT del 1er fragmento, canal dcho

X2 = fft(x2); % FFT del 2º fragmento, canal dcho

t = (1:M)/fm; % Base de tiempos

f = t*fm.^2./M; % Base de frecuencias

%% REPRODUCCIÓN SONORA ESTÉREO DE LAS SECUENCIA

sound([[x1d,x2d]',[x1i,x2i]'],fm); % reproduce la concatenación de ambas secuencias

%% REPRESENTACIÓN GRÁFICA de las dos secuencias

% considerando para ambas el mismo origen de tiempos

% Representación temporal (figura superior)

subplot(2,1,1);

plot(t,x1,t,x2); grid on;

title('2 fragmentos consecutivos de la canción Bristol de Herman Dune [x_1(t), x_2(t)]');

ylabel('x_1(t), x_2(t)'); xlabel('t(s)');

% Representación frecuencial (figura inferior)

subplot(2,1,2);

semilogy(f,[abs(X1).^2;abs(X2).^2]); grid on;

title('Espectro de los fragmentos x_1(t) y x_2(t)')

ylabel('X_1(f), X_2(f)'); xlabel('frecuencia(Hz)');

axis([0 fm/2 0 max(abs(X1))^2]);

end

Referencias

- ↑ Peirce, John R. (1985). Los sonidos de la música. Barcelona: Reverté.

- ↑ Huidobro, José Manuel (2014). Telecomunicaciones. Tecnologías, redes y servicios. Madrid: Ra-Ma.

- ↑ Bellamy, John C. (1982). Digital Telefony. Nueva York: John Wiley & Sons.

- ↑ Unión Internacional de Telecomunicaciones (1988). G.711: Modulación por impulsos codificados (MIC) de frecuencias vocales (Recomendación UIT-T G.711, 11/88). https://www.itu.int/rec/T-REC-G.711-198811-I/es

- ↑ Unión Internacional de Telecomunicaciones (1990). G.726: Modulación por impulsos codificados diferencial adaptativa (MICDA) a 40, 32, 24, 16 kbit/s (Recomendación UIT-T G.726, 12/90). https://www.itu.int/rec/T-REC-G.726/es

- ↑ Unión Internacional de Telecomunicaciones (2021). G.722: Codificación de audio de 7 kHz dentro de 64 kbit/s (Recomendación UIT-T G.722, 09/12). https://www.itu.int/rec/T-REC-G.722-201209-I/es