Receptor

De un modo muy general se entiende por receptor (I. receptor, F. Récepteur, A. Empfänger) a la persona o cosa que se encuentra en el lado receptor durante el acto comunicativo; es decir, el que recibe. Cuando nos referimos a comunicación, cabe pensarse en el proceso mediante el cual se puede transmitir una información a través de un mensaje desde un transmisor hasta un receptor. Éste es, de hecho, el punto de vista de la Teoría Matemática de la Comunicación (TMC; v. Shannon, Comunicación). Trataremos esta perspectiva y la relevancia que tiene la incertidumbre del receptor para el concepto shannoniano de información, pero así mismo trataremos de ir más allá de las intenciones de la TMC para abordar aspectos fundamentales del significado y de la relación entre información y conocimiento.

1. El receptor como componente esencial del modelo de comunicación

Según el modelo de la TMC tanto el transmisor como el receptor son componentes internos del proceso de telecomunicación, dejando fuera la fuente de información, en el extremo inicial, y el destino, en el extremo final. Es tarea del diseño de los sistemas de telecomunicación el lograr que tanto el transmisor como el receptor sean eficientes en la transmisión de los mensajes que van de la fuente al destino usando los medios disponibles para interconectar transmisor y receptor. Así la parte más técnica del proceso comunicativo (ya sea en una comunicación simple o en el más complejo sistema de comunicaciones analógicas o digitales) está constituida por cuatro componentes fundamentales: transmisor, mensaje, medio y receptor (Shannon, 1948).

Transmisor (o emisor): Es el que emite la información.

Mensaje: Contiene la información que se desea transmitir desde el transmisor hacia el receptor a través de un medio (mensaje).

Medio (o canal): Es el elemento físico guiado o no guiado por el cual se transmite la información.

Receptor: Es el que recibe la información.

La TMC se centra en los principios generales de diseño del sistema de comunicaciones para lograr que en la recepción de los mensajes 'codificados' no se cometan errores (o tan pocos como se desee) dadas las limitaciones existentes del medio. Tanto el diseño del código, del transmisor, del receptor o de los medios utilizados para interconectarlos deben responder a este propósito: que el receptor no se confunda. De esa manera el sistema técnico de comunicación interpuesto entre la fuente y el destino se muestra del todo transparente al proceso comunicativo entre ambos (Díaz y Al Hadithi, 2009).

2. El punto de vista de las telecomunicaciones

Desde el punto de vista de las telecomunicaciones, un sistema electrónico de comunicaciones transfiere información de un lugar a otro. Entonces, las comunicaciones electrónicas incluyen la transmisión, recepción y procesamiento de información entre dos o más lugares, mediante circuitos electrónicos. La fuente original de información puede estar en forma analógica (continua), como por ejemplo la voz humana o la música, o en forma digital (discreta), como códigos binarios o códigos alfanuméricos. Sin embargo, todas las formas de información se deben convertir a energía electromagnética antes de ser propagadas a través de un sistema electrónico de comunicaciones (Wayne, 2003).

El objetivo principal de todo sistema de comunicaciones es intercambiar información entre dos entidades. Este intercambio de información implica una gran complejidad. Algunas de las tareas claves que se deben realizar en un sistema electrónico de comunicaciones y redes de computadores son: utilización del sistema de transmisión, implementación de la interfaz, generación de las señales de sincronización, gestión del intercambio, detección y corrección de errores, control de flujo, direccionamiento, enrutamiento, recuperación, formato de mensajes, seguridad y gestión de red (Stallings, 2004), funciones que están distribuidas en los diferentes protocolos del modelo OSI.

3. La medida de la información desde el punto de vista de la incertidumbre del receptor

Se ha mencionado el intercambio de información, pero ¿qué es exactamente la información y cómo se mide? Lograr una medida de la información constituía un aspecto fundamental para lograr los objetivos de la TMC. En la medida que podemos cuantificar los recursos disponibles en términos de: 1) el ancho de banda que puede cursar el medio (recurriendo a las relaciones desarrolladas por Nyquist) y 2) la potencia disponible a la entrada del receptor respecto a la potencia de las perturbaciones o ruido en ese mismo punto (siguiendo las relaciones propuestas por Hartley). Se requiere entonces poder determinar de igual modo la cantidad de información que puede ser intercambiada con dichos recursos. Shannon lo logra mediante una caracterización que es conmesurable con dichos recursos (Teoremas fundamentales de Shannon). Pero además lo logra refiriéndose a una noción general de la información: la sorpresa que se siente cuando se recibe un mensaje. Por ejemplo, el mensaje “El océano ha sido destruido por una explosión nuclear” contendrá más información que el mensaje “Hoy está lloviendo” (Couch, 2008). Si se nos comunica algo acerca de una situación que conocemos en todos sus detalles no se nos está informando en absoluto (al menos acerca de esa situación) por mucho que en el proceso comunicativo se haya producido intercambio de señales.

La información enviada de una fuente digital cuando se transmite el j-ésimo mensaje (dejamos de lado las fuentes analógicas por el hecho de que el conjunto de mensajes potenciales es, en principio, ilimitado) está dada por:

- [bits] (1)

Donde pj es la probabilidad de transmitir el j-ésimo mensaje. De esta definición se deduce que los mensajes que tienen una menor probabilidad de ocurrencia (valores más pequeños para pj) suministran más información (valores grandes de Ij). También se observa que la medida de información depende sólo de la probabilidad del envío del mensaje y no de la posible interpretación del contenido en referencia a si tiene sentido o no. No obstante, esa probabilidad de transmisión de mensaje, aparentemente objetiva como caracterización de la fuente, ¿no refleja a su vez la incertidumbre del receptor respecto a que va a transmitirse? De hecho, podría argumentarse que el transmisor o la fuente sí podría saber lo que va a transmitir antes de hacerlo, el que desde luego lo desconoce es el receptor. El código usado, que en el modelo de la TMC es un componente compartido por el transmisor y el receptor, crea una simetría que puede hacer confundir este hecho: la incertidumbre pertenece propiamente al receptor.

Si se piensa en estos términos, la caracterización matemática de la información propuesta en (1) es extraordinariamente natural. Si el mensaje a transmitir tiene probabilidad 1/2, es equivalente al resultado de lanzar una moneda. O es cara o es cruz, basta responder con un sí o un no a una pregunta bien planteada para saber lo que fue el caso. Si la probabilidad fuera de 1/4, por ejemplo, 1 de 4 posibles mensajes equiprobables, nos bastará plantear dos preguntas (esto es el log24). En general si la probabilidad es 1/M, bastarán N=log2M distinciones binarias; o a la inversa si hacemos N distinciones binarias consecutivas podemos referirnos a 2N casos diferentes equiprobables. Por tanto, puede generalizarse que la cantidad de información mínima que se requiere, en términos de distinciones binarias N para saber lo que es el caso (si se plantean preguntas adecuadas) es precisamente lo descrito por (1). La utilización del logaritmo en base 2, propuesta por Hartley, es uno de los puntos de partida sobre los que Shannon desarrolla la TMC.

4. Entropía, capacidad de canal y recepción óptima

Para lograr el objetivo de la TMC antes mencionado:

"The system must be designed to operate for each possible selection, not just the one which will actually be chosen since this is unknown at the time of design." (Shannon, 1948: 1)

Por tanto, debe caracterizarse la fuente de un modo que considere simultáneamente todos los posibles mensajes; para ello Shannon simplemente promedia la información aportada por cada mensaje según la relación (1), llegando así a la famosa medida de la cantidad de información o entropía:

- [bits] (2)

Con esta caracterización la TMC logra el objetivo antes mencionado de lograr que los recursos del canal sean conmensurables con la información a transmitir por el canal. La capacidad del canal supone precisamente el nexo entre la máxima información que puede llegar a recibir el receptor y los recursos de ancho de banda y relación señal a ruido (S/N) (Teoremas fundamentales de Shannon).

Para aproximarse al límite al que se refiere la capacidad de canal, el medio de transmisión debe ser eficiente y confiable, reduciendo en lo posible las dificultades de transmisión, tales como, la atenuación, el ruido y las interferencias, que pueden distorsionar o eliminar la información. Del mismo modo, tanto transmisor como receptor deben regirse por protocolos de comunicaciones, para que, hablando en el mismo idioma, la comunicación pueda realizarse de forma exitosa. Por lo tanto, una vez recibido el mensaje, el receptor lo decodifica, procesa, extrae la información y proporciona una respuesta, haciendo posible una comunicación dúplex (full-duplex) (v. modos de transmisión).

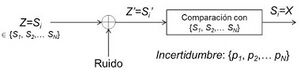

De acuerdo a la TMC, la estructura del receptor óptimo, representado en la figura 2, es equivalente a la de un sistema que compara el mensaje codificado disponible a la entrada del receptor con el conjunto de posibles mensajes transmitidos y toma la decisión (basada en unos umbrales que dependen de la distribución de probabilidad de los mensajes) de que el mensaje transmitido fue uno determinado. El diseño del sistema de transmisión digital puede hacerse de modo que el error de dicha decisión sea tan pequeño como se desee.

Hasta aquí, al igual que en la TMC, nos hemos movido en un terreno fundamentalmente sintáctico de la comunicación. La consideración de algunos problemas semánticos fundamentales requiere transgredir los umbrales del modelo de comunicación de la TMC.

5. Reducción de incertidumbre vs emergencia de significados

Definida la información en los términos de la TMC, obsérvese, como se decía antes, que la probabilidad de ocurrencia de los mensajes no implica una referencia puramente objetiva del comportamiento del transmisor, sino más bien el estado de incertidumbre del receptor. Antes de haberse producido la transmisión éste no sabe lo que va a ser el caso, pero existe un conocimiento tácito de la fuente de información: sabe que este mensaje es más probable que aquel, etc., e incluso hay algunos mensajes que son simplemente imposibles. Consideremos precisamente estos. Su probabilidad sería 0 y según el modelo de la TMC la información que aporta sería infinita. Cuando tratamos de hacer el promedio de todos los mensajes para caracterizar la "entropía" shannoniana de la fuente (v. Shannon) no sabemos qué hacer: considerar la cantidad infinita de información de estos mensajes archi-raros con un peso cero, o simplemente descartarlos para no caer en camisas de once varas. Esta constituye, de hecho, lo que Floridi denomina la paradoja de Bar Hillel-Carnap (Floridi, 2011).

La paradoja es en realidad solo aparente ya que matemáticamente puede demostrarse que la fórmula de la entropía shannoniana (2) es convergente y esos términos no aportan nada al valor global. Pero lo relevante para entender el punto de vista de la TMC es que ésta considera que el conjunto de posibles mensajes es finito. La reducción que hace la TMC de la comunicación –a solamente sus aspectos sintácticos– deja de lado la emergencia de los significados (Díaz Nafría, 2011; Díaz y Al Hadithi, 2009). Podemos decir que la caracterización sintáctica de la comunicación hace un retrato ergódico de la misma y por tanto deja de lado que pueda decirse algo nuevo, lo cual es evidentemente una característica esencial de la comunicación en el proceso de permanente adaptación de los comunicandos a las circunstancias cambiantes (Contexto). Esto debe tenerse en cuenta –a nuestro juicio– a la hora de aplicar el modelo de incertidumbre a un estudio de la información que considere los aspectos semánticos: el conjunto de mensajes es en última instancia abierto pero podemos reducir la complejidad de nuestro caso de estudio descartando aquellos cuya probabilidad sea muy reducida y considerando el modelo resultante como localmente válido. Donde esta validez puede referirse a un punto de metaestabilidad del sistema de comunicación (constituido por los comunicandos, los medios de comunicación y el conjunto de referentes, lo cual necesariamente incluye el contexto, v. Comunicación) y por tanto con la conciencia de que necesariamente cambiará en el tiempo.

6. Información potencial vs actual y la relación entre información y conocimiento

Bajo estos preceptos podemos decir que el modelo de información de Shannon se refiere, muy directamente, a la reducción de la incertidumbre de un receptor que conoce bien todo lo que puede llegar a decirse (lo cual puede representarse en términos del espacio de probabilidad de los mensajes) pero que no sabe qué es lo que en un determinado momento va a transmitir la fuente. Esa incertidumbre equivale a su vez a información potencial.

Si, de acuerdo al modelo descrito en la sec.1, consideramos lo comunicado como mensaje y que el mensaje está a su vez constituido por un conjunto de signos (o señales), el proceso de recepción del mensaje supone la recepción consecutiva de signos. A medida que la comunicación avanza la incertidumbre se va reduciendo y la información potencial se va actualizando (usando la distinción que fue acertadamente introducida por Weizsäcker, 1971). Cuando el último signo ha sido recibido, toda la incertidumbre inicial se ha eliminado y la información es ahora información actual: la incertidumbre inicial respecto a cuál va a ser el mensaje transmitido, se convierte ahora en certidumbre.

Desde esta perspectiva la medida cuantitativa de la información (en bits) nos proporciona el número mínimo de distinciones binarias que sería necesario hacer para saber cuál es el caso en el contexto de una comunicación finita. Un código Huffman trata de hacer esto en el plano sintáctico, pero obsérvese que en el plano semántico es lo que Aristóteles procura hacer en su organización del conocimiento según categorías apropiadas (ser inanimado o animado, etc). Éstas son las que permiten al observador conocer el objeto de observación mediante un reconocimiento de las esencias generales y específicas. Es tarea del científico determinar por vía inductiva las esencias generalesestructuradas en una taxonomía apropiada; mientras que sería tarea del observador que hace uso de dicha taxonomía la de determinar por vía deductiva la esencia del objeto observado a partir de las observaciones.

Podemos usar el modelo del receptor óptimo de la TMC descrito más arriba (sec.4) para representar esta operación de reconocimiento de las formas (o esencias) generales y específicas del objeto de observación: el observador compara con las formas generales de lo corporal vs lo espiritual; de lo vivo vs lo mineral; del animal vs lo vegetal, y así sucesivamente hasta determinar las formas específicas. Una taxonomía adecuada que permita recorrer de un modo eficiente el árbol de las especies sería análogo a la representación arbórea de un código Huffman. Pero obsérvese que en ambos casos se está tratando de un modelo de comunicación cerrado. Esto es, se determina respectivamente: a qué especie pertenece un objeto de observación dentro de un conjunto dado de estas, o qué mensaje perteneciente al código Huffman ha sido transmitido. Por tanto, la información aporta al receptor el conocimiento de lo que es el caso cuando éste parece conocer de antemano todo lo que eventualmente pueda ser el caso.

Desde esta perspectiva la información se encuentra en relación directa y diacrónica con el conocimiento: antes de ser recibida la información (potencial) está correlacionada con la incertidumbre (el desconocimiento de lo que es el caso), pero una vez recibida, la información actual es conocimiento en el sentido de saber lo que es el caso. Sin embargo, es claro que esto no se corresponde con lo que quizá constituya la porción más importante del "conocer": el de descubrir una realidad que ni tan siquiera pertenece al conjunto de realidades que sabemos que pudieran ser el caso. Las categorías predeterminadas no nos permiten entender los fenómenos observados, y éstos resultan a su vez insuficientes por sí mismos para determinar nuevas categorías que hagan posible una comprensión adecuada de esa realidad inapreensible. Como se ha discutido en otros lugares (Díaz Nafría, 2011; Zimmermann y Díaz, 2012; Díaz y Zimmermann 2013a, 2013b) ni la vía deductiva de razonamiento, ni la inductiva antes referidas sirven para explicar la emergencia de los nuevos significados que se requieren para alcanzar un conocimiento genuinamente nuevo y más acertado de los fenómenos observados. En su lugar, el razonamiento abductivo nos conduce a encontrar nuevas categorías con los que referirnos a los que es el caso de un modo radicalmente nuevo, de hecho, a menudo recomponiendo de un modo drástico nuestro esquema de expectativas de lo que eventualmente sea el caso.

Inclusive los aportes previos de información tendrían ahora un lugar distinto en el nuevo espacio de conocimiento ya que desde el nuevo estado de conocimiento lo que eventualmente pueda ser el caso es inconmensurable con lo que previamente se suponía. Así el conocimiento en general no puede verse como meramente acumulativo -ganado a partir de la recepción de información- sino que en determinados momentos se producen saltos cualitativos que alteran nuestros modos de ver el mundo o una realidad más específica (cf. Kuhn, 1962). En un contexto meramente comunicativo nuestras categorías verbales pueden verse seriamente alteradas y con ello el esquema de las expectativas respecto a los mensajes que eventualmente pudieran llegar al receptor o destino de la comunicación. Esta alteración del código y del receptor hace que cualitativa y cuantitativamente la información potencial y actual cambie.

Referencias

- COUCH, W.L.(2008). Sistemas de Comunicaciones Digitales y Analógicas. Pearson Educación, México.

- DÍAZ NAFRÍA, J.M. (2011). "Messages in an open universe." En Messages and Messengers; Capurro, R., Holgate, J., Eds.; Fink Verlag: Munich, Germany, pp. 195–228.

- DÍAZ NAFRÍA, J.M.; AL HADITHI, B. (2009). Are “the semantic aspects” actually “irrelevant to the engineering problem”?. TripleC 2009, 7, 300–308.

- DÍAZ NAFRÍA, J.M.; ZIMMERMANN, R. (2013a). "The emergence and evolution of meaning. The GDI revisiting programme. Part 2: regressive perspective." Information, 4(2), 240-261.

- DÍAZ NAFRÍA, J.M.; ZIMMERMANN, R. (2013b). "Emergence and evolution of meaning." Triple C, 11(1), 13-35.

- FLORIDI, L. (2011). The Philosophy of Information. Oxford, UK: Oxford University Press.

- KUHN, T.S. (1962). The Structure of Scientific Revolutions. Chicago 1962.

- SHANNON, C. E. (1948). "A Mathematical Theory of Communication." The Bell System Technical Journal, Vol. 27 (July, October).

- STALLINGS, W. (2004). Comunicaciones y Redes de Computadores. Madrid: Pearson Educación.

- UNESCO (1996). La Sociedad de la Información para todos. París: Ediciones UNESCO.

- UNESCO (2005). Hacia las Sociedades del Conocimiento. París: Ediciones UNESCO.

- WAYNE, T. (2003). Sistemas de Comunicaciones Electrónicas. México: Pearson Educación.

- WEIZSÄCKER, C.F. von (1971). Die Einheit der Natur. Hanser: Muenchen, Germany (disponible en inglés "The unity of nature").

- ZIMMERMANN, R.; DÍAZ NAFRÍA, J.M. (2012). The emergence and evolution of meaning. The GDI revisiting programme. Part 1: progressive perspective. Information, 3(3), 472-503.