Fuente de información

[gL.edu] Este artículo recoge contribuciones de Rubén Guzmán, elaboradas en el contexto de la Clarificación conceptual en torno a la "Transmisión Digital", bajo la supervisión de José María Díaz Nafría [JDíaz].

Definición

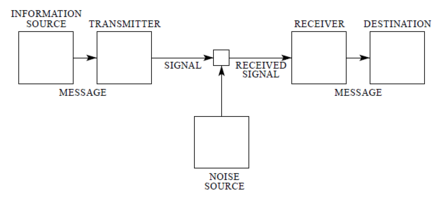

En el ámbito de las telecomunicaciones, una fuente de información se refiere a cualquier entidad que genera mensajes para ser transmitidos a través de un sistema de comunicación, según el modelo definido por Claude E. Shannon en A Mathematical Theory of Communication (1948) [1], que sienta las bases de la teoría de la información.

Estos mensajes son procesados por el transmisor para generar señales que puedan ser emitidas por el canal de comunicación, que es el medio usado para su transmisión al receptor. Las señales que atraviesan el canal pueden verse modificadas por fuentes de ruido. El receptor realiza el proceso inverso del transmisor para recuperar los mensajes originales y entregarlos al destino.

La fuente de información puede modelarse matemáticamente mediante un conjunto de símbolos y sus probabilidades de ocurrencia, entendiendo los mensajes generados por la fuente como sucesiones de símbolos. Esto nos permite cuantificar la cantidad de información proporcionada por la fuente mediante la definición de entropía.

Si se representa la probabilidad de ocurrencia de cada uno de los símbolos que puede producir la fuente mediante , y los símbolos consecutivos son estadísticamente independientes entre sí, se define entropía o cantidad de información de la fuente (expresada en bits) como: .

La aplicación de este modelo requiere que los mensajes de la fuente sean discretos.

Clasificación de las fuentes y digitalización

Los mensajes proporcionados por la fuente de información a lo largo del tiempo están representados mediante señales. Según la naturaleza de estas señales, las fuentes de información se pueden clasificar en:

- Analógicas. Generan señales continuas en el tiempo que toman valores en un intervalo continuo (por ejemplo, la voz que se envía en un sistema telefónico).

- Digitales. Generan señales discretas en el tiempo que toman valores entre un conjunto de valores discretos (por ejemplo, el texto que se envía en un sistema telegráfico).

Un gran número de fuentes de información naturales son analógicas y requieren de un proceso de digitalización para poder aplicar los modelos matemáticos de la teoría de la información. La digitalización de la señal de una fuente analógica se consigue en tres etapas:

- Muestreo. Toma de muestras de una señal continua en el tiempo en instantes discretos de tiempo, obteniendo una señal de valores continuos en instantes de tiempo discretos.

- Cuantificación. Conversión de los valores continuos tomados en el muestreo a valores discretos, obteniendo una señal de valores discretos en instantes de tiempo discretos.

- Codificación. Representación del valor cuantificado como una secuencia de símbolos.

Referencias

- ↑ Shannon, C.E. (1948). A Mathematical Theory of Communication. The Bell System Technical Journal, 27, 379–423, 623–656.